近日,宇泛研究院推出具身大脑的关键阶段性成果——空间认知大模型Manas (末那)。Manas基于当前最先进的多模态大模型架构,加入了3D世界表征能力。 无需显式的3D建模,模型可以从自我 观测的 视频流中学习到真实世界的关键空间信息,极大简化了具身系统框架,并为具身 智能体 构建了强大的空间认知基座。

背景

具身智能的感知鸿沟

具身智能体要在真实世界中实现有效互动,关键不仅在于“看懂”图像的语义内容,更在于具备对三维空间的准确感知能力。物体的实际尺寸、相对方位、空间布局等几何信息,是支撑路径规划、物体操作、环境理解等复杂任务的基础。如果没有这些信息,智能体很难真正“理解”所处的环境,也就难以自主地做出合理决策。“AI教母”李飞飞在最新访谈中也表示:“在我看来,没有空间智能,通用人工智能就不完整。”

目前的多模态大模型,虽然在图像识别、语言理解等感知任务上表现出色,但在空间感知方面仍存在明显短板。例如,它们往往难以准确判断物体的大小、方向或在场景中的相对位置,这在复杂环境下会直接影响具身智能体的执行能力与鲁棒性。因此,想要推动具身智能向更高水平发展,提升空间理解能力已经成为一道关键课题。

方法

融合视觉语义与空间特征的 多模态 大模型

.png)

简洁有效的双流模型结构。 Manas是一个融合了视觉语义和空间特征的多模态大模型,使用双流视觉编码器,分别用于编码视觉语义信息和空间布局信息;使用时空压缩Q-Former模块来减少输入视频帧的信息冗余度;使用decoder-only的大语言模型结构来进行高效统一的视觉语言建模,以理解复杂多样的场景和用户指令。

空间认知与通用能力协同的两阶段训练。 为了让模型在保持基本的视觉语义和语言理解能力情况下,获得良好的三维世界感知能力,研究人员精心设计了训练集:从仿真环境和真实世界采样并制作了大量的空间理解数据,并混合了适当比例的通用视觉理解和自然语言理解数据集。模型训练采用渐进式两阶段策略。第一阶段只训练视觉映射层和ST Q-Former,对齐视觉和语言特征空间;第二阶段将LLM部分也加入训练,让大模型更好地学习到如何去理解视觉空间特征。

性能卓越

定义空间理解新标杆

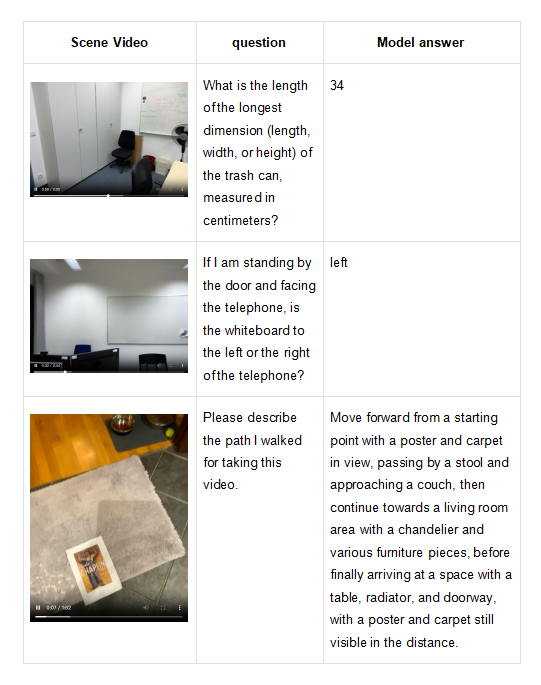

在业界流行的空间理解数据集VSI-Bench,SQA3D上,我们对Manas进行了评测。这些评测集的衡量维度包括目标计数、绝对/相对距离、物体尺寸、路径规划、物体出现顺序、第一人称视角的空间关系等,是具身机器人在真实世界采取有效动作的重要依据。

与业界同等规模的模型相比,Manas取得了SOTA成绩。

.png)

Manas可以结合常识和视觉特征,对真实世界的空间距离、方位关系等进行感知,从而对具身机器人的行为提供有价值的决策。此外,模型还保持了良好的通用视觉理解能力和语言能力,可以实现流畅的人机自然语言交互。

开启具身智能空间认知新篇章

Manas的发布,标志着宇泛智能在具身智能三维空间感知与理解这一核心能力上取得了重要进展。通过创新的双流编码架构、时空信息压缩技术和无显式建模的3D表征学习,有效弥合了语义理解与空间认知之间的鸿沟。在业界公开测试集的领先效果,不仅验证了Manas技术路线的先进性,更彰显了宇泛智能推动具身智能技术向更高实用化水平突破的决心与实力。Manas将为宇泛的智能机器人及各类具身智能应用注入关键的空间智能能力,推动人机共融新范式的实现。

PS:以上模型版本截至2025.7.15

关于Manas:

宇泛空间认知大模型“末那”是佛教术语,源自梵语Manas(मनस्),音译为“末那识”,是唯识学(Yogācāra)中的核心概念之一,指第七识(即“我执识”),功能是产生自我意识与分别心。